فایل Robots.txt چیست؟ درباره Robots.txt چه می دانید؟ آیا می دانید چه کاربردی دارد؟ نحوه ساخت این فایل را می دانید؟ با صبح وب همراه باشید تا به معرفی و برسی این فایل مهم بپردازیم و ببینیم چه نقشی در بهینه سازی موتور های جستجو دارد؟

همان طور که می دانید، برای معرفی و خواندن اطلاعات یک وبسایت و معرفی آن به موتور های جستجو ، ربات هایی در نظر گرفته شده است که توسط گوگل گسترش یافته اند. حال این ربات های گسترش یافته باید بتوانند به سایت های مختلف دسترسی پیدا کنند و محتوا های داخل سایت ها را ایندکس کنند.

برای این راه، یک روش بسیار ساده و حیاتی وجود دارد. این روش، استفاده از یک فایل متنی به اسم Robots.txt است. با درج دستورات در این فایل می توانید کارهای مختلفی از جمله دسترسی یا عدم دسترسی به محتوا های سایت را بدهید.

فایل Robots.txt چیست ؟

Robots.txt فایلی است که به عنکبوت های موتورهای جستجو دستور می دهد کدام صفحات یا بخشهای خاصی از وبسایت شما را دیده و آن ها را ایندکس کنند و کدام صفحات را نادیده بگیرند. اکثر موتورهای جستجوی (از جمله گوگل، بینگ و یاهو) درخواست های Robots.txt را می شناسند و به آنها احترام می گذارند.

جهت مشاهده آدرس دسترسی فایل، بعد از وارد کردن آدرس سایت خود به مانند زیر عبارت robots.txt را وارد نمایید.

فایل robots.txt چگونه کار می کند؟

این فایل از یک سری دستورات استفاده می کند. دستوراتی که اغلب از آنها استفاده خواهید کرد عبارتند از User-Agent ، Allow ، Disallow ، delay-Crawl و Sitemap می باشند که در ادامه به معرفی هر کدام از آن ها می پردازیم.

دستور User-Agent :

دستور User-Agent، ربات هایی را که می خواهید مجموعه فعلی دستورات Allow و Disallow را روی آنها اعمال کنید، شناسایی می کند. می توانید آن را روی * تنظیم کنید تا همه ربات ها را هدف قرار دهید. همچنین می توانید با تعیین مقادیری مانند Googlebot و Bingbot لیست ربات ها را محدود کنید.

دستور Sitemap :

این دستور همان طور که از اسمش پیداست نقشه سایت شما را برای کراولر ها(خزنده ها) نشان می دهد. می توانید این دستور را در ابتدا یا انتهای فایل خود اضافه نمایید. لازم به ذکر است که می توانید بیش از یک نقشه سایت تعریف کنید.

دستور delay–Crawl :

با استفاده از این دستور ، شما می توانید ربات های موتور های جستجو گر را وادار کنید برای برسی و خواندن صفحات شما به نوبتی که توسط شما تعیین می شود صبر کنند. به عبارتی دیگر ، این دستور مشخص می کند که یک ربات موتور جستجو چقدر باید بین بارگذاری صفحات منتظر بماند. لازم به ذکر است که این دستور روی بعضی از ربات ها از جمله Googlebot قابل استفاده نیست. جهت استفاده از این ربات در گوگل می توانید از کنسول جستجوی گوگل استفاده نمایید.

دستور Allow :

به ربات های موتور جستجو اجازه می دهد به فایل یا فایل های مشخص شده دسترسی داشته باشند. این دستور وقتی به کار میاد که بخواهید زیر شاخه های یک فهرست که عدم دسترسی دادید رو اجازه دسترسی بدهید.

دستور : Disallow

این دستور در واقع به ربات ها می گوید که چه فولدر هایی از سایت شما را ایندکس نکنند.

به عنوان مثال شما می خواهید موتور های جستجو تصاویر سایت شما را ایندکس نکنند. برای این کار باید تمام تصاویر سایت را داخل یک پوشه در هاستینگ خود قرار دهید و با استفاده از دستوری که در ادامه توضیح می دهیم دسترسی موتورهای جستجو را قطع کنید.

چه صفحاتی نباید ایندکس شوند ؟

برخی از صفحاتی که باید توسط فایل robots.txt از ایندکس شدن جلوگیری شوند، موارد زیر است.

- صفحاتی که دارای محتوای تکراری هستند.

- فیلتر های صفحه محصول مانند رنگ، قیمت

- صفحه هایی که با سرچ کردن در خود سایت ایجاد می شوند.

- صفحات ادمین و پنل سایت

- صفحه پروفایل کاربران

- صفحه چت

- بعضی از فایل های قالب که دلیلی برای ایندکس شدن توسط گوگل ندارند.

نکاتی درباره فایل robots.txt :

- فایل txt رو دقیقا به این شکل «robots.txt» بنویسید نه به شکلtxt، robots.TXT و … زیرا این فایل به حروف بزرگ و کوچک حساس است.

- باید توجه داشته باشید که یک سری از ربات های مخرب هیچ توجهی به فایل txt شما ندارند و تمام محتوا را کراول می کنند.

- فایل های txt به صورت عمومی در دسترس هست و می توانید فایل robots.txt هر سایتی را که بخواهید ببینید. فقط کافیست عبارت /robots.txt را به آخر دامنه مورد نظر اضافه کنید تا تمام دستور های سایت مشخص شود.

درج صحیح دستورات robots.txt :

- اگر قصد دارید موتور های جستجو گوگل محتوا سایت شما رو ایندکس نکنند می توانید از دستور زیر استفاده کنید :

2. اگر قصد دارید تمام محتوا سایت ایندکس شوند ولی یک فولدر خاص محدود شود می توانید از دستور زیر استفاده نمایید:

3. ممکن است بخواهید از خزیدن رباتها در تمام فایلهای یک فهرست به جز یک فایل جلوگیری کنید. در این صورت، قانون زیر را اجرا کنید:

4. یکی دیگر از راههای کاهش ترافیک رباتهای جستجو در سایت، افزودن دستور تاخیر خزیدن به txt است. تأخیر خزیدن مقدار زمانی را تعیین می کند (بر حسب ثانیه) که یک ربات باید قبل از خزیدن صفحه بعدی منتظر بماند. در مثال زیر، یک تاخیر خزیدن یک دقیقه (60 ثانیه) اضافه کرده ایم

5. استفاده از این دستور سبب مسدود شدن دسترسی ربات های گوگل به ایندکس کردن تمامی تصاویر موجود در سایت می شود.

6. اگر فقط قصد دارید یک تصویر را در موتور های جستجوی گوگل مسدود کنید باید از کد دستوری زیر استفاده کنید.

7. برای محدود کردن فایل هایی با فرمت خاص در همه بخش های سایت می توانید از دستور زیر استفاده کنید:

چرا از robots.txt در وردپرس استفاده کنیم؟

اگر یک وب سایت وردپرسی به تازگی ساخته اید که محتواهای زیادی هم ندارد نیاز چندانی به robots.txt نخواهید داشت. در مقابل، در وبسایتهای بزرگتر، یک فایل robots.txt اصلاح شده به طور چشم گیری می تواند به رتبهبندی و سرعت صفحه شما کمک کند.

موتورهای جستجو برای هر وبسایتی که ایندکس میکنند، بودجه خزیدنی(Crawl Budget) را تعیین میکنند.

بر اساس بودجه ای که دارید خزنده های گوگل در یک دوره زمانی تعدادی از صفحات شما را کراول می کنند.

اگر تعداد صفحات ایندکس شده شما بیشتر از بودجه خزیدن شما باشد، کل وب سایت شما تا زمان خزیدن بعدی ایندکس نمی شود. اگر رباتها بودجه خزیدن خود را در بخشهای نامربوط یا خصوصی سایت شما هدر دهند و مهمترین صفحات شما را از دست بدهند، پیامدهای منفی برای رتبهبندی جستجوی ارگانیک شما دارد.

فایل robots.txt به شما امکان میدهد به موتورهای جستجو بگویید از کدام قسمتها بگذرند، بنابراین محتوای اصلی خود را در اولویت قرار می دهید. با برخی ویرایشهای جزئی در این فایل، به رباتهای جستجوگر کمک میکنید تا صفحات ارزش مند شما را ایندکس کنند.

چگونه یک فایل robots.txt در وردپرس بسازیم ؟

شما می توانید robots.txt را در وردپرس با استفاده از یک افزونه یا به صورت دستی ویرایش کنید. در این بخش، نحوه استفاده از دو افزونه محبوب برای انجام کار را به شما آموزش خواهیم داد.

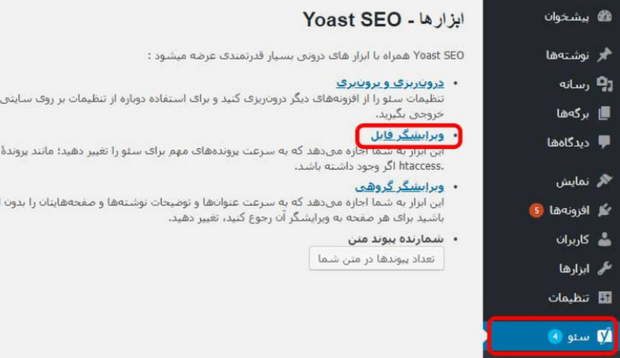

استفاده از Yoast SEO

مطمئنن با این پلاگین محبوب آشنایی دارید. این محبوب ترین افزونه سئو برای وردپرس است و به شما امکان می دهد پست ها و صفحات خود را برای موتور های جستجو بهینه کنید. جدای از آن، در مورد افزایش خوانایی محتوای شما نیز به شما کمک می کند، به این معنی که افراد بیشتری می توانند از آن لذت ببرند.

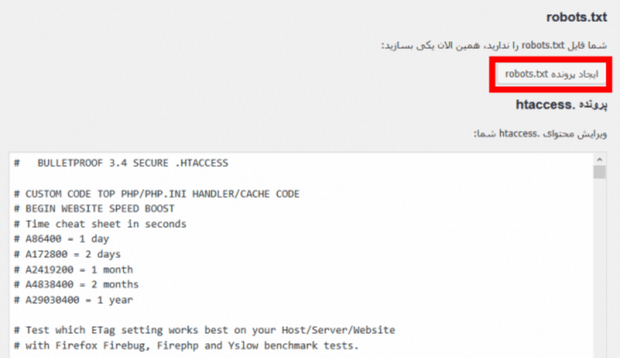

پس از نصب و فعال سازی افزونه، به تب سئو > ابزار ها در داشبورد خود بروید و بر روی ویرایشگر فایل کلیک نمایید. در صفحه ای که باز می شود، فایل Robot.txt قبلی به شما نشان داده می شود و اگر تا به حال این فایل را نداشتید، می توانید در این صفحه یکی بسازید.

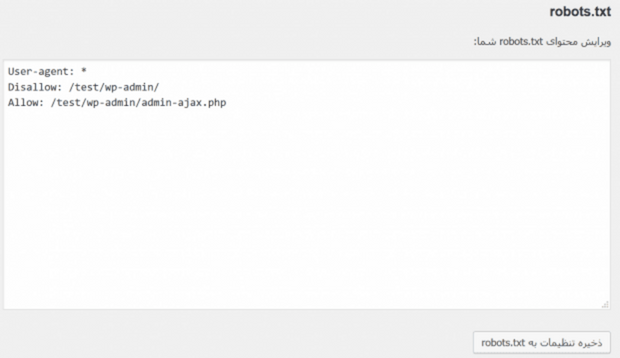

پس از کلیک بر روی این دکمه، تب ویرایشگر جدیدی را نشان می دهد که در آن می توانید فایل robots.txt خود را مستقیماً تغییر دهید. البته لازم به ذکر است که Yoast SEO به صورت پیش فرض یک سری دستورات قرار داده است. شما می توانید دستورات جدیدی را حذف یا اضافه کنید و با ذخیره تغییرات این دستورات عملی می شوند

استفاده از All in One SEO Pack :

پلاگین All in One SEO یکی از محبوب ترین افزونه های سئو می باشد که تا به الان نزدیک به 2 میلیون نصب فعال داشته است. استفاده از این افزونه بسیار راحت می باشد و شما با چند کلیک می توانید فایل robots.txt خود را ایجاد کنید.

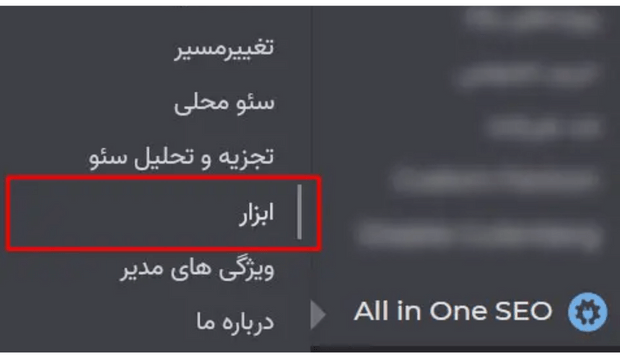

در ابتدا افزونه All in One SEO را از مخزن وردپرس دانلود و نصب نمایید. بعد از نصب و فعال سازی افزونه برای ایجاد فایل robots.txt باید به مسیر All in One SEO رفته و گزینه ابزار را انتخاب نمایید.

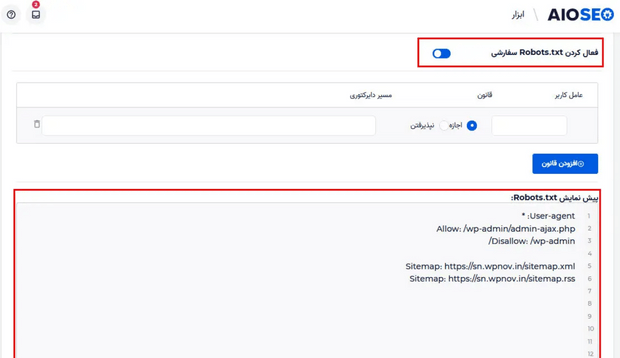

در این صفحه باید گزینه ” فعال کردن robots.txt سفارشی” را فعال نمایید. با فعال شدن این گزینه، فایل robots.txt شما ساخته می شود.

در قسمت پیش نمایش robots.txt می بینید که این افزونه به صورت پیش فرض دستوراتی را اعمال کرده است.

اگر قصد دارید که قوانین جدیدی اعمال کنید، باید روی دکمه افزودن قانون کلیک کنید و سپس قوانینی سفارشی ای برای بهبود سئو سایت خود اضافه نمایید.

در این مرحله ابتدا باید عامل کاربر (User-agent) خود را وارد کنید. اگر قصد دارید همه ربات ها شامل این قانون شوند باید از * استفاده کنید.

گزینه بعدی دسترسی یا عدم دسترسی به موتور های جستجو گری می باشد که انتخاب کردیم. اگر اجازه رو بزنید موتور های جستجو محتوا رو کراول می کنند و اگر نپذیرفتن رو بزنید محتوای شما رو کراول نمی کنند.

بعد از آن هم باید نام فایل و مسیر دایرکتوری خود را وارد نمایید.

در آخر تغییرات اعمال شده خود را ذخیره کنید.

چگونه فایل robots.txt وردپرس خود را تست کنیم ؟

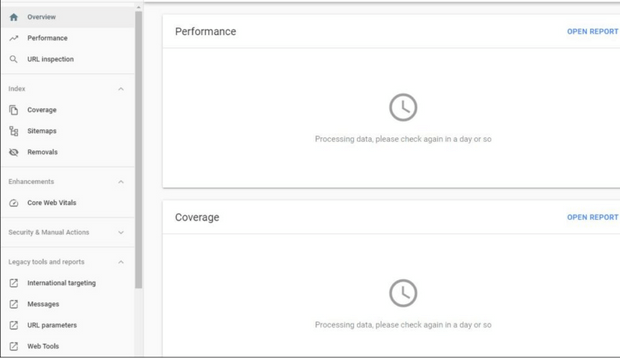

هنگامی که فایل robots.txt وردپرس شما ایجاد و آپلود شد، می توانید از کنسول جستجوی گوگل برای تست خطا استفاده کنید.

- برای این منظور در ابتدا وارد سایت Google Search Console شوید

- سپس روی قسمت Web tools کلیک نمایید.

- گزینه Testing Tools را انتخاب نمایید.

در این صفحه تمام خطاها و هشدار های احتمالی فایل شما را گوگل نشان می دهد.

آیا واقعا به فایل robots.txt نیاز داریم؟

به طور پیش فرض، یک وب سایت به طور معمول توسط موتور های جستجو خزیده و خوانده می شود، حتی بدون وجود فایل robots.txt

بنابراین اجباری برای استفاده از این فایل نیست. دانیل روچ، متخصص سئوی وردپرس، توضیح میدهد، «اگر میخواهید تمام صفحات، محتوا و رسانههای خود را ایندکس کنید، از فایل robots.txt استفاده نکنید: هیچ فایدهای برای شما ندارد» .